内容目录

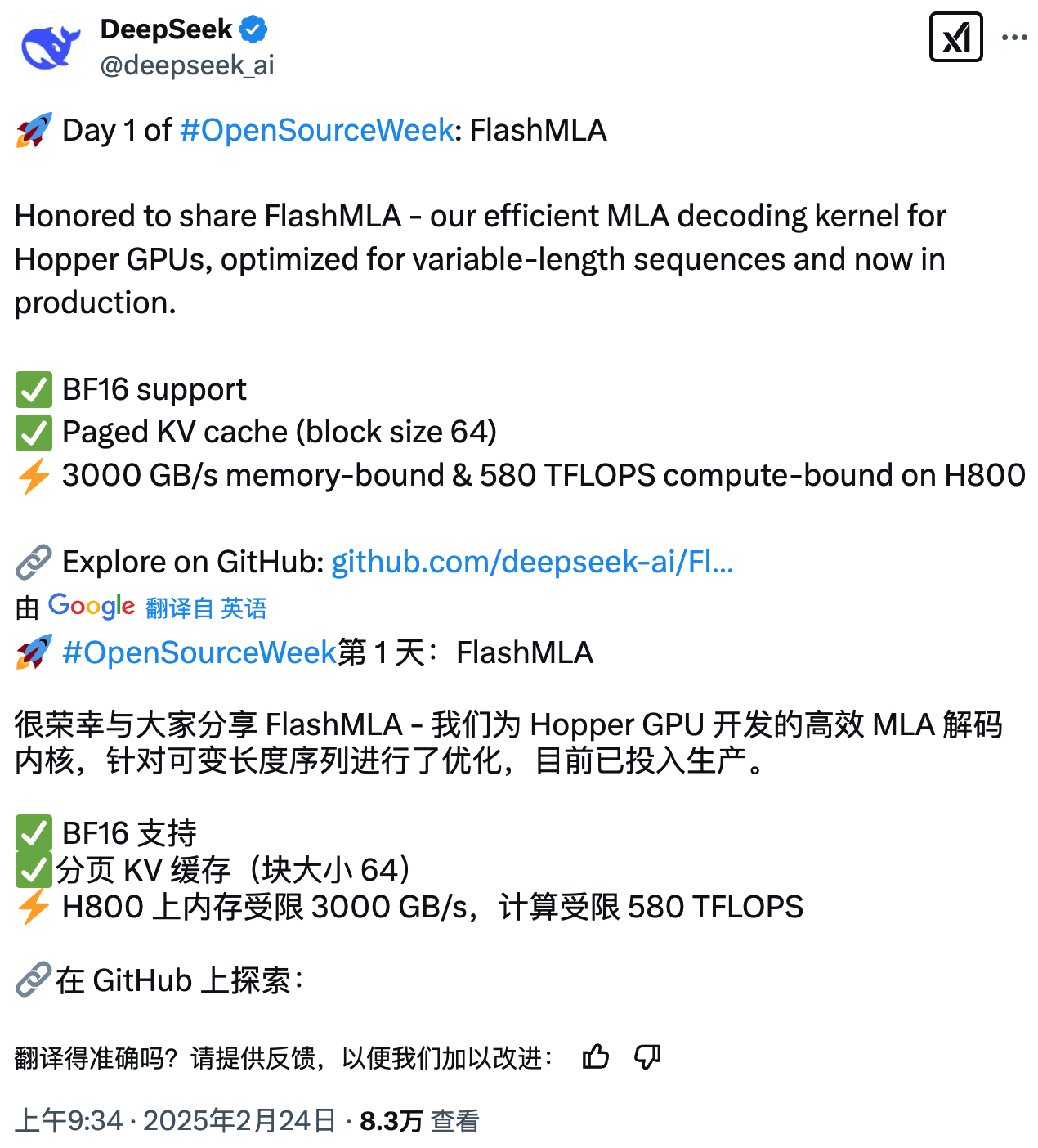

DeepSeek “开源周” 今日正式开启,首个开源的代码仓库为 FlashMLA—— 针对 Hopper GPU 优化的高效 MLA 解码内核,专为处理可变长度序列而设计,目前已投入生产环境。

据介绍,FlashMLA 专门针对多层注意力机制进行了优化,能够加速 LLM 的解码过程,从而提高模型的响应速度和吞吐量。FlashMLA 可在 H800 芯片上实现最高 3000GB/S 的带宽和 580 TFLOPS 的算力。

GitHub 地址:https://github.com/deepseek-ai/FlashMLA

Comments NOTHING