一、参数规模与模型特性

DeepSeek-R1系列通过参数量的阶梯式设计,构建了完整的AI能力矩阵。作为系列中最轻量级的成员,1.5B模型仅需3GB显存即可运行,这种紧凑的结构使其能够轻松部署在智能手机或物联网设备中,处理基础的文本分类、关键词提取等任务。当参数规模提升到7B时,模型开始展现初步的逻辑推理能力,这使其成为个人开发者和初创团队验证AI创意的理想选择。

进入两位数参数领域,14B模型在保持相对亲民的硬件需求(单卡A6000可运行)的同时,已经能够胜任代码生成、文案创作等专业级任务。而32B参数的版本则标志着企业级应用的起点,其多模态理解能力可支撑智能客服、文档分析等复杂场景。当参数量突破70B大关,模型展现出接近人类的常识推理水平,但这种能力的代价是需要至少四张H100显卡组成的计算集群。

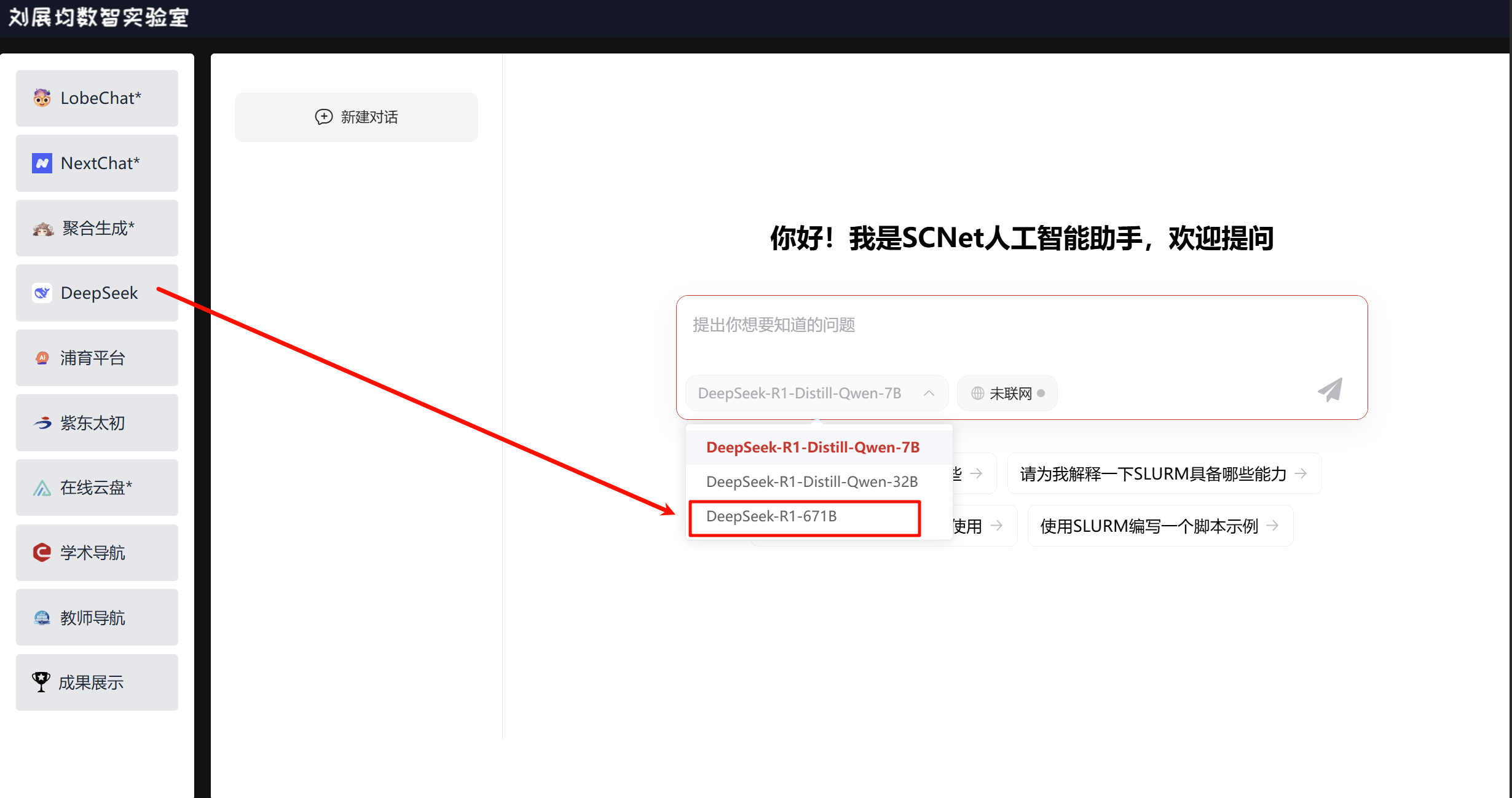

作为皇冠上的明珠,671B超级模型本质上是一个技术试验平台。其训练消耗的32PB语料数据,相当于人类文明所有印刷书籍内容的300倍。这种规模的模型主要服务于国家级科研机构和超大规模云服务商,用于探索AGI的潜在路径。

关键参数对比:

最小显存需求:1.5B (0.8GB) → 671B (336GB)

推理延迟跨度:7B (120ms) → 671B (3.8s)

训练能耗比:70B模型每参数能耗比14B降低37%

DeepSeek-R1系列模型覆盖从1.5B到671B的参数跨度,形成完整的技术栈:

微型模型(1.5B-7B):适用于移动端部署,处理基础NLP任务

标准模型(8B-14B):平衡性能与成本的主力模型

企业级模型(32B-70B):处理复杂语义理解和生成任务

超级模型(671B):面向科研机构和大规模云服务

二、训练成本对比

模型的训练成本呈现超线性增长特征。1.5B模型的训练仅需8张A100显卡工作三天,总成本控制在8000美元以内,这使小型研究团队也能参与模型微调。但当参数量达到70B级别时,训练过程需要256张H100显卡持续运转五周,电力消耗相当于300个美国家庭的年用电量,280万美元的成本门槛将参与者限制在科技巨头范围内。

在推理阶段,成本控制呈现完全不同的逻辑。7B模型在RTX 3090显卡上的单次推理成本不到0.001美元,这种经济性使其能够支撑千万级日活的应用场景。而671B模型的每次推理都需要调度32张H100显卡,即使用云服务的弹性算力,这决定了它只能应用于高附加值的专业领域,如药物分子设计或气候模拟预测。

成本拐点分析:

训练成本临界点:14B模型(18万美元)是学术机构与产业界的分水岭

推理经济性平衡点:32B模型在批处理模式下单位成本下降72%

隐性成本因素:70B以上模型需要专业AI运维团队,人力成本占比超总成本30%

模型规模 训练硬件需求 训练时间 预估成本(美元)

1.5B 8×A100 80G 3天 8,000

7B 32×A100 80G 7天 45,000

14B 64×A100 80G 14天 180,000

32B 128×A100 80G 21天 550,000

70B 256×H100 35天 2,800,000

671B 4096×H100 90天 32,000,000

三、推理成本与硬件需求

消费级显卡的极限在14B参数关口显露无疑。即便采用4-bit量化压缩技术,14B模型仍需占用8GB显存,这意味着想要流畅运行必须使用RTX 4090级别的硬件。而32B模型则彻底关闭了个人设备的大门——即便使用双A100显卡的服务器,也需要精心优化内存交换策略才能避免推理延迟的失控增长。

对于70B及以上的超级模型,部署本质上是一场系统工程。不仅需要构建多卡并行计算架构,还要配套液冷散热系统和冗余电源保障。某头部云服务商的测试数据显示,671B模型在32张H100集群上运行时,瞬时功耗可达12千瓦,这相当于同时运行150台游戏电脑的能耗水平。因此,这类模型的部署往往需要改造数据中心的基础设施。

硬件选择指南:

个人开发者:RTX 3060+(支撑7B模型实时推理)

中小企业:双A100服务器(满足14B模型日均10万次调用)

大型机构:H100集群+定制液冷机柜(针对70B+模型)

那么,理论上讲本地部署可行性如下表:

模型规模 FP16显存需求 4-bit量化显存 最低显卡配置

1.5B 3GB 0.8GB RTX 3050

7B 14GB 4GB RTX 3090

14B 28GB 8GB A6000

32B 64GB 16GB 2×A100 40G

70B 140GB 35GB 4×A100 80G

671B 1.34TB 336GB 32×H100

Comments NOTHING